Τα deepfake είναι βίντεο που έχουν παραποιηθεί με τεχνητή νοημοσύνη και αποτελούν μια αυξανόμενη ανησυχία για κυβερνήσεις, υπηρεσίες επιβολής του νόμου, ακόμη και άτομα. Το πρώτο βήμα για να προστατευτείτε από τέτοιες απειλές είναι η εκπαίδευση – μάθετε πώς να αναγνωρίζετε αυτές τις παραποιημένες εικόνες και τι πιθανή βλάβη θα μπορούσαν να προκαλέσουν σε όλους. Ας αναλύσουμε περαιτέρω.

Τι είναι ένα deepfake;

Ορισμός του deepfake

Το deepfake είναι μια μορφή τεχνητών μέσων που δημιουργείται με την αξιοποίηση τεχνικών τεχνητής νοημοσύνης (AI) και βαθιάς μάθησης (deep learning). Η τεχνολογία deepfake παράγει ρεαλιστικές εικόνες, ήχο ή φωτογραφίες ανθρώπων που κάνουν ή λένε κάτι που δεν έκαναν ποτέ, χρησιμοποιώντας προϋπάρχουσες εικόνες και βίντεο.

Μπορείτε να το ονομάσετε εξέλιξη του Photoshop, το οποίο μπορεί να χρησιμοποιηθεί για την παραποίηση εικόνων πραγματικών ανθρώπων σε καταστάσεις στις οποίες συνήθως δεν θα βρίσκονταν. Τα deepfakes παραπλανούν το κοινό κάνοντάς το να πιστεύει ότι το απεικονιζόμενο άτομο εκτέλεσε ενέργειες ή είπε δηλώσεις που δεν έκανε ποτέ στην πραγματικότητα, συχνά για κακόβουλους σκοπούς.

Πώς λειτουργούν τα deepfakes;

Τα deepfakes αξιοποιούν τη βαθιά μάθηση και την γενετική τεχνητή νοημοσύνη για να δημιουργήσουν εξαιρετικά ρεαλιστικό περιεχόμενο. Ο πυρήνας της τεχνολογίας deepfake έγκειται στη χρήση νευρωνικών δικτύων (Neural Nets), μιας τεχνικής που ονομάζεται «γενετικό ανταγωνιστικό δίκτυο» ή GAN. Ένα GAN αποτελείται από δύο κύρια στοιχεία: μια γεννήτρια (generator) και έναν διακριτή (discriminator).

Εκπαιδεύονται να αναγνωρίζουν μοτίβα χρησιμοποιώντας αλγόριθμους. Η γεννήτρια δημιουργεί ψεύτικες εικόνες ή βίντεο, ενώ ο διακριτικός τα εξετάζει και μπλοκάρει περιεχόμενο που αναγνωρίζει ως ψεύτικο.

Η γεννήτρια και ο διακριτικής μηχανής εμπλέκονται σε έναν συνεχή βρόχο. Η γεννήτρια βελτιώνει την έξοδό της για να ξεγελάσει την μηχανή του διακριτή και ο διακριτής μηχανής ενισχύει την ικανότητά του να ανιχνεύει ψεύτικα δεδομένα.

Με την πάροδο του χρόνου, η γεννήτρια παράγει εξαιρετικά ρεαλιστικά ψεύτικα μέσα που μπορεί να είναι δύσκολο να διαφοροποιηθούν από το αυθεντικό περιεχόμενο. Η διαδικασία συνήθως ξεκινά με ένα μεγάλο σύνολο δεδομένων εικόνων ή βίντεο του ατόμου-στόχου.

Ο αλγόριθμος deepfake τα αναλύει για να μάθει τις εκφράσεις του προσώπου, τις κινήσεις του σώματος και άλλες αποχρώσεις του υποκειμένου. Η γεννήτρια χρησιμοποιεί αυτά τα δεδομένα εκπαίδευσης για να παράγει ψεύτικο περιεχόμενο.

Τα deepfake παρουσιάζουν πώς η Τεχνητή Νοημοσύνη μπορεί να χειραγωγήσει τα μέσα με εντυπωσιακούς τρόπους. Φανταστείτε ένα βίντεο στο οποίο το πρόσωπο μιας διασημότητας τοποθετείται απρόσκοπτα στο σώμα ενός άλλου ατόμου, κάνοντάς το να φαίνεται σαν η διασημότητα να εκτελεί ενέργειες ή να λέει λέξεις που δεν είπε ποτέ στην πραγματικότητα. Ωστόσο, αυτή είναι μόνο μία από τις πολλές εφαρμογές της τεχνολογίας deepfake.

Deepfakes κειμένου

Τα deepfakes κειμένου περιλαμβάνουν τη χρήση τεχνητής νοημοσύνης για τη δημιουργία πειστικού ψεύτικου κειμένου. Αυτή η τεχνολογία μπορεί να δημιουργήσει ρεαλιστικά άρθρα και ειδήσεις ή ακόμα και να μιμηθεί το στυλ γραφής κάποιου σε email και μηνύματα.

Η Τεχνητή Νοημοσύνη αναλύει μεγάλα σύνολα δεδομένων κειμένου για να μάθει και να μιμηθεί τον τρόπο που ένα άτομο γράφει ή μιλάει. Ενώ αυτό μπορεί να είναι χρήσιμο για την αυτοματοποίηση της δημιουργίας περιεχομένου, ενέχει σημαντικούς κινδύνους. Οι άνθρωποι μπορούν να χρησιμοποιήσουν deepfakes κειμένου για να διαδώσουν ψευδείς πληροφορίες ή να εξαπατήσουν άτομα ώστε να πιστέψουν ότι επικοινωνούν με κάποιον που εμπιστεύονται, προκαλώντας σημαντική βλάβη.

Deepfakes βίντεο

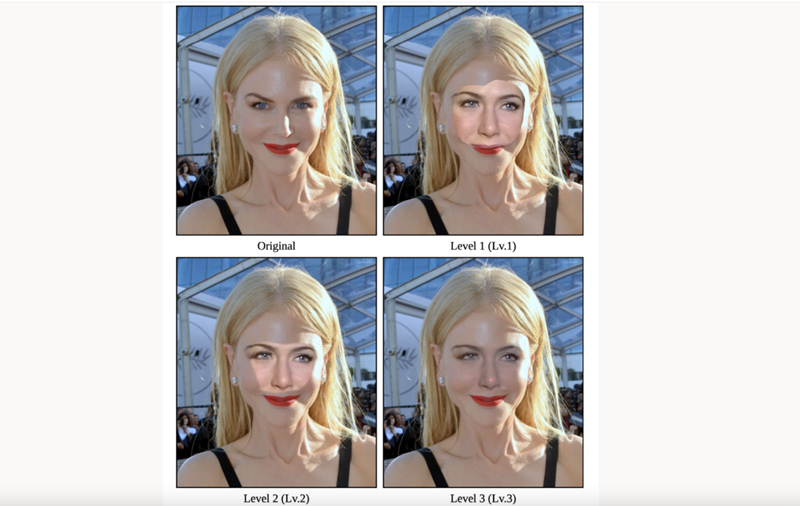

Τα βίντεο deepfake χρησιμοποιούν προηγμένες τεχνικές Τεχνητής Νοημοσύνης για να δημιουργήσουν ρεαλιστικά ψεύτικα βίντεο ανταλλάσσοντας πρόσωπα ή αλλάζοντας εμφανίσεις. Η διαδικασία περιλαμβάνει τη χρήση νευρωνικών δικτύων για τη χαρτογράφηση και την κίνηση των χαρακτηριστικών του προσώπου, κάνοντας το τροποποιημένο βίντεο να φαίνεται γνήσιο. Τα βίντεο που δημιουργούνται από τεχνητή νοημοσύνη εγείρουν σοβαρά ηθικά ζητήματα.

Οι εγκληματίες μπορούν να χρησιμοποιήσουν τέτοια βίντεο για να κατασκευάσουν γεγονότα, να δημιουργήσουν ψεύτικες ειδήσεις ή να μιμηθούν άτομα, οδηγώντας σε παραπληροφόρηση, βλάβη στη φήμη και πιθανά νομικά ζητήματα. Μια ανησυχητική απειλή είναι η κυβερνοαπαγωγή, όπου οι απατεώνες χρησιμοποιούν τεχνολογία deepfake για να δημιουργήσουν ψεύτικα βίντεο ομήρων, κάνοντάς το να φαίνεται σαν να έχει απαχθεί ένα θύμα. Αυτά τα πειστικά ψεύτικα μπορούν να χρησιμοποιηθούν για την απόσπαση χρημάτων από τις οικογένειες των θυμάτων, προσθέτοντας ένα νέο επίπεδο κινδύνου στο ψηφιακό έγκλημα.

Ηχητικά deepfakes

Η τεχνολογία ήχου deepfake χρησιμοποιεί την Τεχνητή Νοημοσύνη για να δημιουργήσει ρεαλιστική ομιλία που μιμείται τη φωνή ενός ατόμου.

Η Τεχνητή Νοημοσύνη αναλύει τις φωνητικές ηχογραφήσεις ενός στόχου και παράγει ένα ηχητικό κομμάτι που ακούγεται ακριβώς όπως αυτό το άτομο. Οι άνθρωποι μπορούν να χρησιμοποιήσουν αυτήν την τεχνολογία για να δημιουργήσουν δόλιες ηχογραφήσεις και να μιμηθούν άλλους για κακόβουλους σκοπούς. Για παράδειγμα, οι απατεώνες μπορούν να χρησιμοποιήσουν ηχητικά deepfakes για να πραγματοποιήσουν ψεύτικες τηλεφωνικές κλήσεις και να αποσπάσουν χρήματα.

Ζωντανά deepfakes

Τα ζωντανά deepfakes περιλαμβάνουν χειραγώγηση σε πραγματικό χρόνο των ροών βίντεο και ήχου για την αλλαγή της εμφάνισης και της φωνής ενός ατόμου κατά τη διάρκεια ζωντανών μεταδόσεων ή βιντεοκλήσεων. Αυτή η τεχνολογία μπορεί να χρησιμοποιηθεί για εμπειρίες εικονικής πραγματικότητας, ζωντανές παραστάσεις ή διαδραστικά παιχνίδια, παρέχοντας καθηλωτικές και συναρπαστικές εμπειρίες. Ωστόσο, η πιθανότητα κακόβουλης χρήσης είναι σημαντική.

Τα ζωντανά deepfakes μπορούν να επιτρέψουν την πλαστοπροσωπία κατά τη διάρκεια βιντεοδιασκέψεων, τη διάδοση ψευδών πληροφοριών ή τη διεξαγωγή δόλιων δραστηριοτήτων.

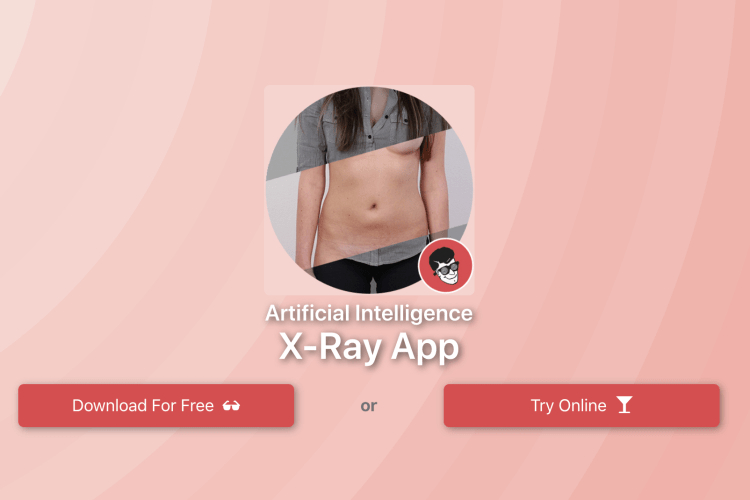

Γυμνά bots Deepfake

Τα γυμνά bots Deepfake χρησιμοποιούν Τεχνητή Νοημοσύνη για να δημιουργήσουν σαφείς εικόνες ή βίντεο ανθρώπων χειραγωγώντας υπάρχον περιεχόμενο χωρίς τη συγκατάθεσή τους. Ένα διαβόητο παράδειγμα είναι το bot deepfake του Telegram. Οι ερευνητές ανακάλυψαν ότι αυτό το bot πλαστογράφησε γυμνές φωτογραφίες άνω των 100.000 γυναικών. Ο αλγόριθμος Τεχνητής Νοημοσύνης του bot αντικαθιστά τα ενδυματολογικά μέρη μιας εικόνας που έχει ανεβάσει με τεχνητά δημιουργημένο γυμνό. Οι κυβερνοεγκληματίες κοινοποίησαν τις εικόνες στο διαδίκτυο, στοχεύοντας κυρίως γυναίκες, με ορισμένες να είναι ανήλικες.

Οι κυβερνοεγκληματίες προώθησαν το bot μέσω διαφόρων πλατφορμών κοινωνικής δικτύωσης, κυρίως Telegram και VKontakte. Τέτοιες περιπτώσεις bot ανεβάζουν τις deepfake απειλές σε νέο επίπεδο, επειδή αφορούν ιδιώτες και είναι επικίνδυνα προσβάσιμες.

Εάν έχετε ανεβάσει τουλάχιστον μία φωτογραφία κάπου στο διαδίκτυο, θα μπορούσατε εύκολα να γίνετε πιθανό θύμα διαδικτυακού εκφοβισμού.

Η διαδικτυακή εγρήγορση είναι ζωτικής σημασίας για την πρόληψη τέτοιων απειλών. Ο περιορισμός του περιεχομένου που κοινοποιείτε δημόσια μπορεί να εμποδίσει τους απειλητικούς παράγοντες να χρησιμοποιούν αυτό το περιεχόμενο για κακόβουλες δραστηριότητες.

Υπάρχει θετική περίπτωση χρήσης για τα deepfakes;

Μπορείτε να χρησιμοποιήσετε την τεχνολογία deepfake για διάφορους θετικούς σκοπούς, όπως η δημιουργία ρεαλιστικών παλαιωμένων εκδοχών αγνοουμένων, ρεαλιστικές απεικονίσεις ιστορικών γεγονότων ή η ενίσχυση του ρεαλισμού στα παιχνίδια.

Ωστόσο, η παραγωγή και η διανομή deepfakes δεν απαιτεί καμία μορφή συμφωνίας. Η χρήση της εικόνας ενός άλλου ατόμου για περιεχόμενο χωρίς τη συγκατάθεσή του είναι ηθικά και συχνά και νομικά λανθασμένη. Η πιθανή κακή χρήση των deepfakes μπορεί να οδηγήσει σε παραπληροφόρηση, παραβιάσεις απορρήτου και δυσφήμιση.

Πώς δημιουργούνται τα deepfake βίντεο;

Παρόλο που η τεχνολογία τεχνητής νοημοσύνης deepfake εξακολουθεί να εξελίσσεται, είναι ήδη πολύ προηγμένη και ικανή να παράγει ρεαλιστικά αποτελέσματα γρήγορα με ελάχιστη ανθρώπινη παρέμβαση. Διάφορες δωρεάν εφαρμογές, όπως το Wombo και το FaceApp, επιτρέπουν σε οποιονδήποτε να δημιουργήσει deepfake μέσα. Ενώ αυτά τα προγράμματα μπορεί να παράγουν λιγότερο πειστικά αποτελέσματα, αντιπροσωπεύουν την αρχή αυτού που είναι δυνατό με αυτήν την τεχνολογία.

Πώς να αναγνωρίσετε ένα deepfake

Δεν είναι πάντα εύκολο να εντοπίσετε ένα deepfake. Ενώ ορισμένα βίντεο είναι σαφώς ψεύτικα, με τις εκφράσεις του προσώπου να παρουσιάζουν ένα παράξενο εφέ, άλλα είναι πιο εξελιγμένα. Αρκετοί παράγοντες μπορούν να σας βοηθήσουν να προσδιορίσετε αν βλέπετε ένα πειστικό deepfake ή όχι.

Εάν το βίντεο περιέχει ένα πρόσωπο, εστιάστε την προσοχή σας εκεί και αναζητήστε αυτά τα χαρακτηριστικά: Ομαλά ή θολά σημεία Τα σημεία σύνδεσης όπου η επικάλυψη βίντεο deepfake συναντά το πρόσωπο του ατόμου από κάτω μπορεί μερικές φορές να φαίνονται περίεργα ομαλά και χωρίς υφή. Ακόμα και με καλύτερα παραδείγματα, τυχόν ξαφνικές κινήσεις του κεφαλιού ή αλλαγές στον φωτισμό μπορούν να αποκαλύψουν στιγμιαία θολά περιγράμματα του προσώπου.

Ανακριβή χαρακτηριστικά που δεν αφορούν το πρόσωπο

Εάν το βίντεο αντιπροσωπεύει ένα δημόσιο πρόσωπο, όπως έναν πολιτικό, μπορείτε να βρείτε πραγματικές εικόνες αυτού του ατόμου για σύγκριση. Εξετάστε στοιχεία εκτός των κύριων χαρακτηριστικών του προσώπου που μπορεί να μην έχουν αλλοιωθεί – χέρια, μαλλιά, σχήμα σώματος και άλλες λεπτομέρειες που δεν συγχρονίζονται μεταξύ του εν λόγω βίντεο και παλαιότερων, πιο αξιόπιστων οπτικών πηγών.

Αφύσικη κίνηση

Ενώ το deepfake είναι μια σχετικά νέα τεχνολογία, τα τελευταία χρόνια έχει βελτιωθεί πολύ και το deepfake μπορεί πλέον εύκολα να αναδημιουργήσει τις κινήσεις ενός ατόμου. Ωστόσο, ορισμένες λεπτομέρειες μπορούν ακόμα να αποκαλύψουν ένα deepfake.

Αν το σώμα και το κεφάλι του θέματος φαίνονται περίεργα άκαμπτα, αυτό θα μπορούσε να είναι ένα σημάδι ότι οι δημιουργοί του βίντεο προσπαθούν να διευκολύνουν την τεχνητή νοημοσύνη βαθιάς μάθησης να αντιστοιχίσει μια εικόνα στο πρόσωπο του ατόμου χωρίς να χρειάζεται να παρακολουθεί υπερβολική κίνηση.

Μια μη πειστική φωνή

Η τεχνολογία deepfake εξελίσσεται ραγδαία, αλλά προς το παρόν, η εκπαίδευση υπολογιστών για τη δημιουργία προσομοιώσεων ήχου φαίνεται να παράγει χειρότερα αποτελέσματα από τη σύνθεση πειστικών εικόνων και βίντεο deepfake.

Ο δημιουργός του deepfake πρέπει να επιλέξει ανάμεσα σε δύο επιλογές αν θέλει το θέμα του να μιλήσει – είτε να χρησιμοποιήσει μια φωνή που δημιουργείται από τεχνητή νοημοσύνη είτε έναν ηθοποιό που μπορεί να μιμηθεί το αρχικό υλικό. Μπορείτε να συγκρίνετε τη φωνή με τον ήχο ενός διάσημου προσώπου που μιλάει και μπορεί να παρατηρήσετε κάποιες διαφορές.

Είναι τα deepfakes παράνομα;

Η δημιουργία deepfakes δεν αποτελεί έγκλημα.

Ωστόσο, συνδέονται όλο και περισσότερο με εγκληματικές δραστηριότητες όπως η παραπληροφόρηση, οι ψεύτικες ειδήσεις και η δημιουργία κακόβουλου περιεχομένου για ενηλίκους.

Υπάρχουν νόμιμες εφαρμογές, αλλά η πιθανή κακή χρήση τους επισκιάζει τα όποια παραδείγματα.

Οι κυβερνοεγκληματίες χρησιμοποιούν τα deepfakes για να δημιουργήσουν παράνομα άσεμνα βίντεο και εικόνες, συχνά με γυναίκες διασημότητες και δημόσια πρόσωπα.

Έχουν υπάρξει ακόμη και αναφορές για γυμνά bots deepfake που μπορούν να δημιουργήσουν αυτόματα αυτό το υλικό.

Ενώ τα deepfakes δεν είναι εγγενώς παράνομα, τα άτομα που τα δημιουργούν ή τα διανέμουν για παράνομους σκοπούς ενδέχεται να αντιμετωπίσουν ποινικές διώξεις.

Αποτελεί η τεχνολογία deepfake απειλή;

Η τεχνολογία deepfake αποτελεί αρκετές πολύ πραγματικές απειλές για τα άτομα και την κοινωνία γενικότερα. Τα πειστικά deepfakes μπορεί να είναι εξαιρετικά επιβλαβή εάν δημιουργηθούν ως πορνό εκδίκησης και κοινοποιηθούν στο διαδίκτυο, γι’ αυτό και πολλές χώρες αρχίζουν να θεσπίζουν νόμους για την ποινικοποίηση αυτής της δραστηριότητας. Ωστόσο, τα deepfakes αποτελούν αρκετές άλλες αυξανόμενες απειλές, τις οποίες θα εξερευνήσουμε εδώ. Ψεύτικες ειδήσεις και προπαγάνδα

Ένα πειστικό βίντεο deepfake μπορεί να χρησιμοποιηθεί ως προπαγάνδα για τη δυσφήμιση πολιτικών αντιπάλων και αντίπαλων κυβερνήσεων. Για παράδειγμα, μπορούμε να κοιτάξουμε στο 2022, όταν, λίγο μετά τη ρωσική εισβολή στην Ουκρανία, εμφανίστηκαν στο διαδίκτυο deepfakes που έδειχναν τον Ουκρανό πρόεδρο Βολοντίμιρ Ζελένσκυ να παραδίδεται.

Ενώ αυτό το βίντεο αποκαλύφθηκε ως ψεύτικο, είναι εύκολο να φανταστεί κανείς πόσο επιζήμια θα μπορούσε να είναι αυτή η στρατηγική όταν η τεχνολογία γίνει πιο δύσκολη στην ανίχνευση.

Ένα deepfake θα μπορούσε να χρησιμοποιηθεί για να δυσφημίσει έναν πολιτικό αντίπαλο και να επηρεάσει τους ψηφοφόρους. Εναλλακτικά, η ευρεία χρήση αυτής της τεχνολογίας θα μπορούσε να δυσφημίσει ένα πραγματικά ενοχοποιητικό βίντεο.

Εάν η ανίχνευση ενός deepfake βίντεο καταστεί αδύνατη, τα κατασκευασμένα μέσα ενημέρωσης έχουν τη δυνατότητα να υπερεκτιμήσουν τους κινδύνους των ψεύτικων ειδήσεων και να τροφοδοτήσουν την δυσπιστία στα κυρίαρχα μέσα ενημέρωσης.

Απάτες και κοινωνική μηχανική (social engineering)

Η τεχνολογία deepfake θα μπορούσε επίσης να χρησιμοποιηθεί για να ξεγελάσει τους ανθρώπους ώστε να αποκαλύψουν προσωπικές πληροφορίες ή ακόμα και να δώσουν χρήματα με επιθέσεις ηλεκτρονικού “ψαρέματος” (phishing). Μπορεί να είστε καχύποπτοι εάν λάβετε ένα μήνυμα στο Facebook από έναν φίλο που εξηγεί ότι έχει αποκλειστεί στο εξωτερικό και χρειάζεται επείγουσα οικονομική βοήθεια.

Ίσως τον καλέσετε ή του στείλετε μήνυμα σε μια διαφορετική εφαρμογή και ανακαλύψετε ότι ο λογαριασμός του στο Facebook έχει παραβιαστεί. Τώρα φανταστείτε το ίδιο σενάριο, αλλά σας στέλνουν ένα συναρπαστικό βίντεο του φίλου σας αντί για μήνυμα.

Ο ήχος και το βίντεο φαίνονται γνήσια. Τώρα έχετε οπτική απόδειξη ότι έχουν κολλήσει σε ένα αεροδρόμιο χωρίς αρκετά χρήματα για το εισιτήριο επιστροφής. Πολλοί άνθρωποι θα έστελναν τα χρήματα, μη νιώθοντας την ανάγκη να ζητήσουν περαιτέρω διαβεβαίωση – αλλά αυτό που μόλις είδαν θα μπορούσε να είναι ένα deepfake.

Χάρη στην αυξανόμενη πολυπλοκότητα των γενετικών αντιφατικών δικτύων και άλλων συστημάτων μηχανικής μάθησης, ένας απατεώνας θα μπορούσε σύντομα να χρησιμοποιήσει αυτά τα πειστικά βίντεο για να διευκολύνει την κλοπή ταυτότητας και να βοηθήσει σε περαιτέρω απάτες.

Το μέλλον των deepfakes

Καθώς η τεχνολογία βελτιώνεται, θα γίνεται όλο και πιο δύσκολο να εντοπιστούν τα deepfakes. Αν φτάσουμε στο σημείο όπου οποιοσδήποτε με υπολογιστή και βασική κατανόηση του λογισμικού VFX μπορεί να δημιουργήσει ένα βίντεο του προέδρου να λέει κάτι εξωφρενικό, έχουμε πρόβλημα. Είναι ήδη δύσκολο να εντοπίσουμε τα deepfakes, αλλά σύντομα θα μπορούσαν να γίνουν αδύνατο να εντοπιστούν.

Με ένα πολωμένο πολιτικό σύστημα, δεν είναι απίθανο ένα deepfake να χρησιμοποιηθεί ως μέρος μιας μυστικής στρατηγικής προεκλογικής εκστρατείας.

Αν και η χρήση της τεχνολογίας σε πρόσφατες ταινίες και τηλεοπτικές εκπομπές συμβάλλει στην ευαισθητοποίηση του κοινού, πολλοί άνθρωποι θα μπορούσαν ακόμα να παραπληροφορηθούν από ένα πειστικό βίντεο.

Ένα απλό βήμα που μπορείτε να κάνετε σήμερα για να αντιμετωπίσετε τους κινδύνους που θέτουν οι απατεώνες deepfake είναι να περιορίσετε τον αριθμό των εικόνων που δημοσιεύετε στο διαδίκτυο.

Η δημιουργία ενός πειστικού βίντεο που δημιουργείται από τεχνητή νοημοσύνη βασίζεται στο σύστημα που έχει πρόσβαση σε φωτογραφίες και πλάνα του θέματος που προσπαθεί να αναδημιουργήσει. Σας προτείνουμε να διατηρείτε τα προφίλ σας στα μέσα κοινωνικής δικτύωσης ιδιωτικά και να αποφεύγετε να δημοσιεύετε τακτικές εικόνες του προσώπου σας.